阅读:0

听报道

昨日(4月12日),中国首个自动驾驶公交车项目在重庆市永川区正式投入运营,3台L4级自动驾驶公交车(百度巴士)上路载客,标志着中国自动驾驶商业化落地迎来重大突破。随着自动驾驶愈发深入大众生活,人们不禁要问:自动驾驶安全吗?万一出车祸该谁负责?

撰文 | 刘凯(渤海大学教育科学学院、渤海大学通用人工智能研究所)

自动驾驶现已来到关键的历史局点。从百度Robotaxi到宇通WITGO,从到郑东新区到重庆永川,我国装备L3-L4高等级自动驾驶技术的商用车及开放道路渐成规模;但与此同时,L2级自动驾驶事故在耳畔警响,何况还有恶劣天气、临时管制、交通路口、路面落物或反光等更大挑战。在应对全天候全场景行驶工况时,自动驾驶仍有较长的路要走。

据《汽车之心》2019年总结:

2016年1月20日,京港澳高速河北邯郸段,23岁的高雅宁驾驶2014款白色特斯拉ModelS撞车身亡,后被确认为全球首例“自动驾驶”致死车祸;

2016年5月7日,美国佛罗里达州 Wiliston 27 号高速上,40岁的Joshua Brown驾驶2015 款黑色特斯拉 Model S撞车身亡;

2018年3月1日,美国佛罗里达州棕榈滩,50岁的Jeremy Banner驾驶红色特斯拉 Model 3撞车身亡;

2018年3月18日,美国亚利桑那州坦佩市,一台Uber 自动驾驶测试车在自动驾驶模式下撞上正推着自行车横穿马路的白人女性 Elaine Herzberg ,并致其死亡,这是全球首例自动驾驶测试车撞死行人事故;

2018年3月23日,美国加州山景城 101 高速,38岁的黄伟伦驾驶2017 款蓝色特斯拉 Model X P100D加速撞上隔离带身亡。

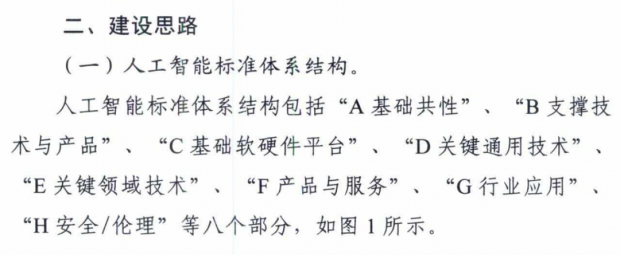

“拥抱”还是“排斥”?这是个难题。事实上,尽管大众当前对自动驾驶的诸多忧虑都是“技术可解”,即,通过改进技术方案或强制人工介入的方式妥当解决,但技术问题之外的相关领域却聚讼不断,并以伦理为最。2020年8月,国家标准化管理委员会、中央网信办、国家发展改革委、科技部、工业和信息化部等五部门联合印发《国家新一代人工智能标准体系建设指南》,指南中也明确设立“H安全/伦理”类,意图规范人工智能服务对传统道德伦理和法律秩序产生的冲击。

截选自《国家新一代人工智能标准体系建设指南》

然而,人工智能内部有着不同的技术路线,总体上可分为专用人工智能与通用人工智能两类(详情参见返朴文章《人工智能与心理学的迷思》)。二者具有不同的前提假设和理论依据,对相同问题便有不同的解读和回答,因此需要区别对待。在自动驾驶领域,专用人工智能路线对应L1-L4级,而通用人工智能则对应L5级。本文将针对专用人工智能路线下自动驾驶的伦理问题进行讨论,首当其冲的便是经典的“电车难题”。

让我们设想一辆疾驶的电车,前方是两条支线,每条支线上都站有数量不等的无辜平民,电车驶入任何一条支线都会导致平民死亡。请问司机如何抉择?

这是“电车难题”经典却绝非唯一的表述方式,后续相继出现了各种变体。在方向选择矛盾的基础上,自动驾驶又叠加了另一个两难之选:

高速行驶的自动驾驶汽车,避让行人就会导致主驾身亡,不避让便会导致行人死亡。自动驾驶汽车该怎么做?

实际上,自动驾驶的“电车难题”背后,就是两个伦理冲突的算法设定问题:如果相撞不可避免,牺牲自己还是他人;如果牺牲他人不可避免,牺牲多些还是少些。说巧不巧,二者同时也是构筑伦理学大厦的两大基石:主体性及客体价值。

专用人工智能以解决特定领域问题为出发点,通过技术迭代,渐进提升智能化程度。由于其技术路线本身的局限性,解决电车难题存在着以下困难:

专用人工智能对于封闭问题友好,对开放问题十分头疼。专用人工智能其实并不能“思考”,而只能“计算”。“计算”的模式是直接或间接由人工实现的:前者对应的是“人工算法”,即由领域专家直接确定算法规则;后者对应的是“数据算法”,即规则不由人工给出,而从真实数据间接提炼获得。但无论哪种算法,都无法确保对开放问题的涵盖性足够广阔和丰盈。

进一步说,如果放松限制,使得人力和数据的丰富程度得到足够满足,但规则本身却依旧有可能因证据来源差异而产生内部冲突。类似“亲妈和媳妇同时落水,先救谁?”这样的问题,不同回答皆有正面与反面证据,判别的前提出发点不同,结论也必然各异。因此,伦理问题属于经验问题,但经验问题并不等同于计算问题。于是,“电车难题”不可能在专用人工智能框架下直接给出稳定的最优解。

间接的方式是否可行呢?事实上,穷举就是这类最典型的方式。其标准做法是:采集自动驾驶各种环境条件、司机和行人的行为和心理特征,以及汽车的各种参数,继而穷举可能空间的组合,并根据已知“合理”的先验知识、时间序列特征来调整权重网络模型。

这是目前主流人工智能领域深度学习的核心方法。不过,即便自动驾驶汽车的硬件设备足够先进,其计算能力在某一特定时刻依旧是相对不足的,如果离开规范的自动驾驶路段而驶入开放路段,穷举式无法确保在有限时间内总能顺利地感知、运算并返回结果。这体现了专用人工智能所谓“感知智能和计算智能”的根本局限之一——将智能与计算相等同。人类拥有智能,但人类不是电脑,我们不靠升级大脑物理设施提升智力水平。

退一步而言,即使穷举总可执行并返回结果,开放环境的内容仍然是不可能穷尽的,因此自动驾驶系统对开放环境的经验准备也总是相对不足的。这体现了专用人工智能另一个根本局限——知识工程黑洞,即,开放环境的可能空间无法穷尽,总会遇到意外的棘手情况,这意味着程序员无法完备地将伦理规范价值量化后的“道德代码”置入汽车驾驶软件。

再退一步,假如处于理想世界,穷举的方法和内容都能逐一枚举,但此时系统最终决策也会受到巨大挑战。尽管有“大算力”“大模型”“大数据”的加持,仍然无法避免“解释黑箱”的问题——我们无法解释系统是怎样做出决策的。当前自动驾驶路线大多基于统计学习,决策依据更多来自概率而非逻辑模型,决策的信度和效度并不透明,令自动驾驶事故判定变得难度更高。

再退一万步,即使决策的有效性和解释也不是问题,最优化也依旧无解!因为系统会不可避免地陷入“目标悖论”——如果摩托车手知道自动驾驶汽车会优先保护生存概率最低者,他就只能选择不戴头盔,因为佩戴头盔会提高他的生存概率,结果头盔之类的安全措施反而会让他成为高危的移动牺牲者。最终结果便是“劣币驱逐良币”:遵规守纪的人反而会面临更高的事故风险。

因此,在人工智能的语境下,并不总能将伦理冲突转化为合理的经济等价式去进行形式化价值计算,结果导致所有嵌入“道德律令”的做法也永远无法满足开放条件下自动驾驶多样问题的解决。说到底,伦理本质上是价值的“判断”,而非价值的“估算”!专用人工智能没有主体性,无法自主进行价值判断,所以在专用人工智能框架内不存在伦理冲突“技术解”的可能性。

那我们是否就此对自动驾驶宣判“死刑”了呢?不仅不是,而且恰好相反。问题的要害在于,理论层面的伦理与应用层面的责任是两个相关、但不同的问题,很容易被隐蔽地混淆。

“道路千万条,安全第一条”,有科学证据表明,自动驾驶系统比人类驾驶员具有更高的安全性,这种安全性还体现为规模的指数化,即自动驾驶越多,交通的整体通畅和安全水平越好。因此,自动驾驶出行方式是大势所趋。

学界的焦虑主要来自对自动驾驶事故责任的认定。考虑到专用人工智能技术本身的技术特点,L1-L4级自动驾驶的责任问题可分类讨论:

(1)封闭路段。

满足自动驾驶的封闭路段,道路服务商必须能够提供下述基本服务:确保路面畅通、无杂物堆积、标记线和指示牌清晰无误,为重要地点设立智能枢纽,提供异常天气、地质灾害等的预警等。如果道路工况不达标,道路服务商应对自动驾驶事故承担主要责任。

如果道路工况达标,则应检视自动驾驶是否存在硬件或软件故障,部件有问题则由相关厂商承担责任,部件整合搭配问题则有整车制造商承担责任。特别地,如在满足自动驾驶条件下,在车辆前行方向出现了横穿马路的行人或动物,如果是行人违规,则由行人承担责任,如果穿行者是动物,则由道路服务商承担责任。这类似现在的高速公路,汽车可以高速行驶的预设前提是道路服务商为车辆提供必要的全程封闭管制,不允许非机动车或行人在高速公路上穿行。此时,自动驾驶汽车驾驶员不承担事故责任,自动驾驶汽车应该优先保护驾驶员。

(2)开放路段。

在不满足完全自动驾驶条件的开放路段进行自动驾驶,其行为本身已经包含了发生潜在交通危险的可能性。此时,驾驶员如果仍然开启自动驾驶模式前行,不论有意或无意,都已在事实层面实施了自动驾驶行为。如果发生交通事故:

① 我方和对方都遵守交通规则。由驾驶员承担主要责任,由自动驾驶部件或整车制造商承担次要责任。此种情况下,自动驾驶汽车应优先保护驾驶员。

② 我方遵守交通规则,对方违反交通规则。由对方承担主要责任,由驾驶员承担次要责任。此种情况下,自动驾驶汽车应优先保护驾驶员。

③ 我方违反交通规则,对方遵守交通规则。如果因破解系统造成与厂商版本不同,则由驾驶员承担全部责任,否则由自动驾驶部件或整车制造商承担主要责任。此种情况下,自动驾驶汽车应优先保护行人。

④ 我方和对方都违反交通规则。如果因破解系统造成与厂商版本不同,则由驾驶员和对方共同承担责任,否则由自动驾驶部件或整车制造商与对方共同承担责任。此种情况下,自动驾驶汽车应优先保护行人。

综上几种情况,基于专用人工智能技术的自动驾驶系统不存在“机器道德主体地位”问题,机器不能作为法律惩戒对象而必须由责任人来承担责任后果。

事实上,自动驾驶事故责任认定问题,也并未超越现行法律体系的有效调控范围。也就是说,应将自动驾驶系统也视为车辆专用系统的一个基本部分。比如,如果轮胎有缺陷,在正常使用情境下出了问题,则应该由相应的产品提供商负责。但驾驶员明知冰雪路面不该使用普通车胎,却依旧驾驶造成事故的,责任便由本人承担。自动驾驶事故的责任认定也亦如此。

最后,从计算问题、法律问题再回归到伦理问题。在计算层面,自动驾驶没有技术的“伦理解”。但在法律层面,自动驾驶的实际应用没有伦理障碍。

专用人工智能框架下,自动驾驶的核心特征强调工具的自动化(L1-L4)而非自主化(L5)。工具性意味着,只能确保在既定使用范围内正常工作,这是理解自动驾驶合法性和有效性的前提。而在伦理层面的“电车难题”及其变种,本质上都是前提为一对互斥矛盾、且前提必须成立的情况下,寻求化解矛盾的方案。换言之,虽在伦理空间无法突破给定的矛盾预设,但可以试图在法律空间内用经济手段寻求伦理解。因此,不论电车疾驶向哪一条支线,电车司机在法律上都是无责的,负责的反而应该是明知不该、却执拗聚在铁轨上的“无辜”行人。

伦理问题未必都有合理解,有合理解也未必有最优解,这反映了开放世界价值判断的多元化。而多元的价值判断,必然导致很多情况下不存在最优解,而只有可行解甚至无奈解。这意味着,在“元伦理学”范畴内,伦理学系统的“公理化”理论假设本身就面临“非公理化”现实的无情挑战与深刻诘责。因此,尽管我们至今仍在争论电车司机该选择哪条支线,却并不妨碍地铁、汽车、火车、飞机、轮船等各种交通工具的使用越来越多、智能化程度越来越高。

归根到底,在专用人工智能框架下,L1-L4级的自动驾驶伦理难题“不足为惧”:伦理难题既非自动驾驶所专有,也无须自动驾驶技术来终结,更不会成为其应用推广的阻碍。

作者简介

刘凯,博士,华中师范大学心理学博士后,渤海大学教育科学学院教师,教育技术学及心理健康教育硕士生导师,中国通用人工智能(AGI)协会(筹)召集人,机器认知(北京)科技有限公司创始人,研究方向为:通用人工智能(AGI)、机器教育、计算精神病学。

话题:

0

推荐

财新博客版权声明:财新博客所发布文章及图片之版权属博主本人及/或相关权利人所有,未经博主及/或相关权利人单独授权,任何网站、平面媒体不得予以转载。财新网对相关媒体的网站信息内容转载授权并不包括财新博客的文章及图片。博客文章均为作者个人观点,不代表财新网的立场和观点。

京公网安备 11010502034662号

京公网安备 11010502034662号